IK分词器插件

1. 简介

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,我们需要安装中文分词器ik来解决这个问题。

如果要使用中文,建议使用ik分词器!

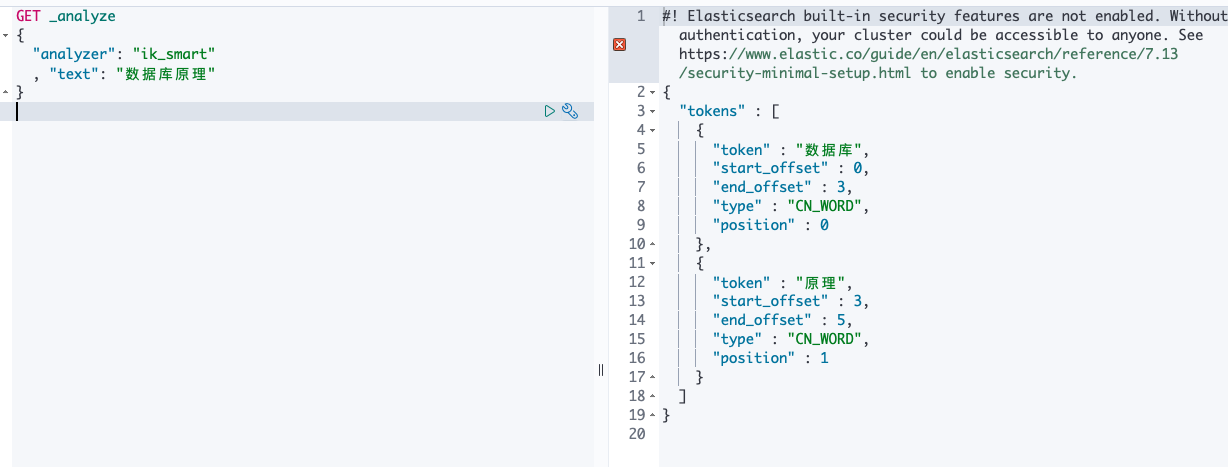

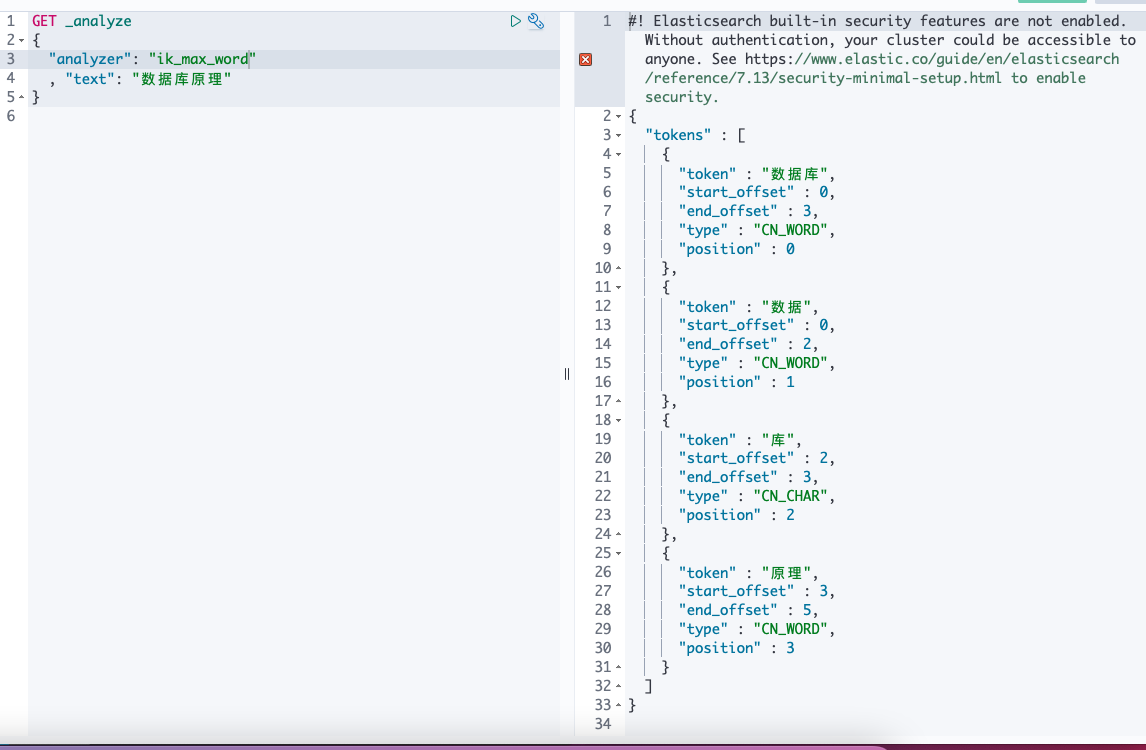

IK提供了两个分词算法:ik_smart 和 ik_max_word,其中 ik_smart 为最少切分,ik_max_word为最细粒度划分!

2. 安装

解压到es的plugin目录下,重启es。

重启kibana,测试。

Image

Image

Image

Image

3. 自造词加到IK中

ik插件config下,新建dic字典文件,注入到IKAnalyzer.cfg.xml中

<entry key="ext_dict">my.dic</entry>